НЕЙРО́ННЫЕ СЕ́ТИ

-

Рубрика: Технологии и техника

-

-

Скопировать библиографическую ссылку:

Книжная версия:

Электронная версия:

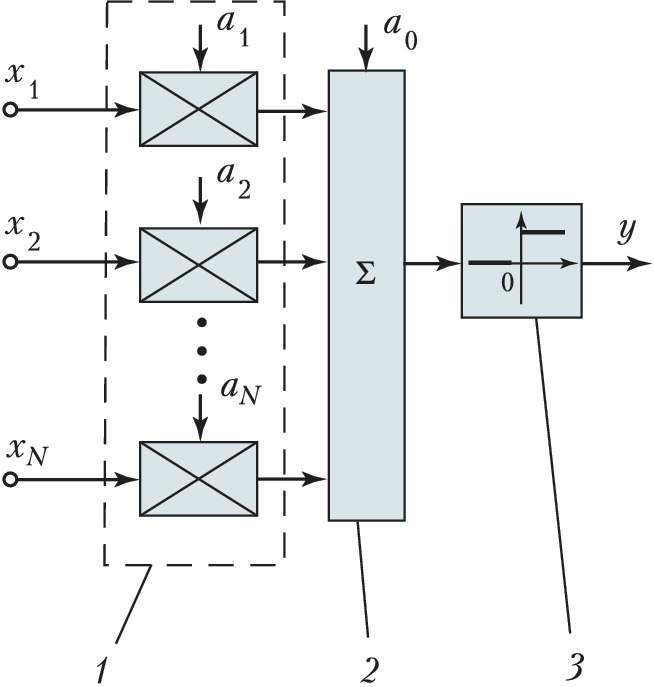

НЕЙРО́ННЫЕ СЕ́ТИ искусственные, многослойные высокопараллельные (т. е. с большим числом независимо параллельно работающих элементов) логические структуры, составленные из формальных нейронов. Появление формального нейрона во многом обусловлено изучением биологич. нейронов. Формальный нейрон представляет собой логич. элемент с N входами, (N+1) весовыми коэффициентами, сумматором и нелинейным преобразователем. Простейший формальный нейрон, осуществляющий логич. преобразование y=sign∑Ni=0aixi входных сигналов (которыми, напр., являются выходные сигналы др. формальных нейронов Н. с.) в выходной, представлен на рис. 1. Здесь y – значение выхода формального нейрона; ai – весовые коэффициенты; xi – входные значения формального нейрона (xi∈{0,1},x0=1). Процесс вычисления выходного значения формального нейрона представляет собой движение потока данных и их преобразование. Сначала данные поступают на блок входа формального нейрона, где происходит умножение исходных данных на соответствующие весовые коэффициенты. Весовой коэффициент является мерой, которая определяет, насколько соответствующее входное значение влияет на состояние формального нейрона. Весовые коэффициенты могут изменяться в соответствии с обучающими примерами, архитектурой Н. с., правилами обучения и др. Полученные (при умножении) значения преобразуются в сумматоре в одно числовое значение g (посредством суммирования). Затем для определения выхода формального нейрона в блоке нелинейного преобразования (реализующего передаточную функцию) g сравнивается с некоторым числом (порогом). Если сумма больше значения порога, формальный нейрон генерирует сигнал, в противном случае сигнал будет нулевым или тормозящим. В данном формальном нейроне применяется нелинейное преобразование:\text{sign}(g)= \begin{cases} 0,\; g < 0, \\ 1,\; g ⩾ 0. \end{cases}

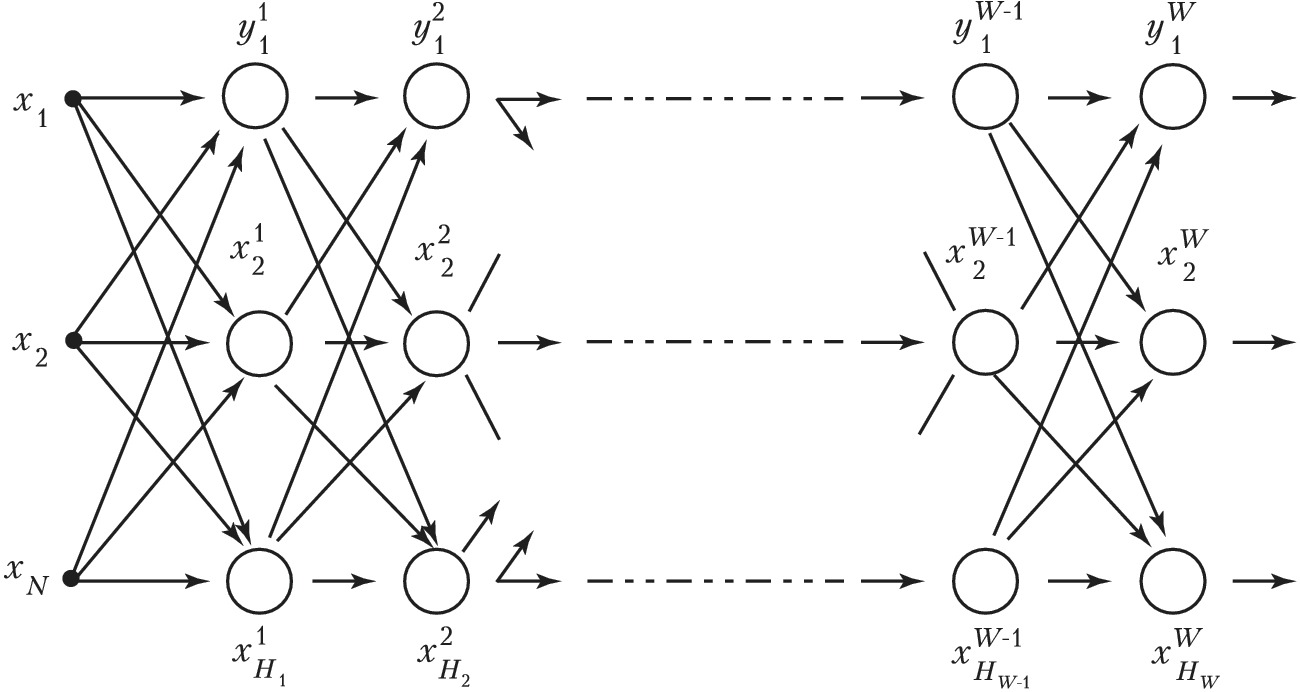

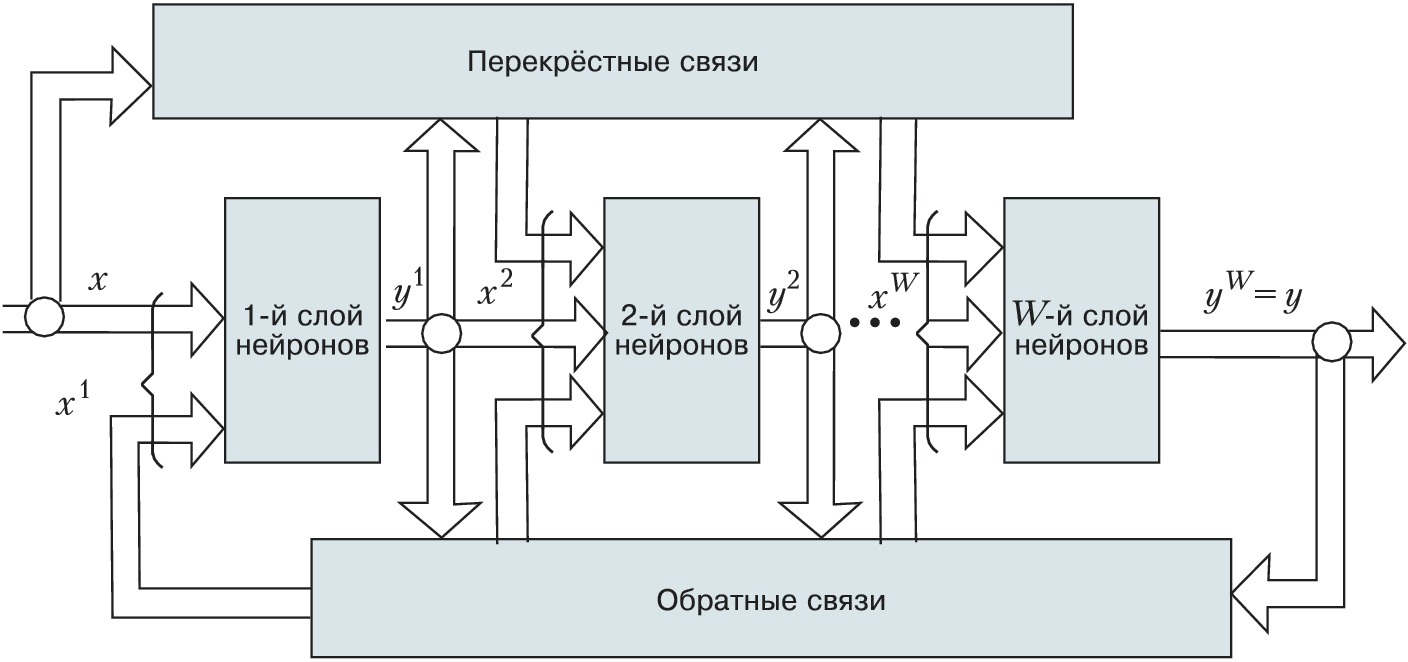

На рис. 2 показана общая схема многослойной Н. с. с последовательными связями. Высокий параллелизм обработки достигается путём объединения большого числа формальных нейронов в слои и соединения определённым образом разл. нейронов между собой. В общем случае в эту структуру могут быть введены перекрёстные и обратные связи с настраиваемыми весовыми коэффициентами (рис. 3).

Начало теории Н. с. положила работа амер. нейрофизиологов У. Мак-Каллока и У. Питтса «Логическое исчисление идей, относящихся к нервной деятельности» (1943), в которой они предложили математич. модель биологич. нейрона. На дальнейшее развитие теории Н. с. существенное влияние оказала монография амер. нейрофизиолога Ф. Розенблатта «Принципы нейродинамики» (1962), в которой он подробно описал схему перцептрона (устройства, моделирующего процесс восприятия информации человеческим мозгом). Его идеи получили развитие в большом числе науч. работ др. авторов. Теория Н. с. продолжает достаточно активно развиваться в нач. 21 в.

Н. с. являются сложными нелинейными системами с огромным числом степеней свободы. Принцип, по которому они обрабатывают информацию, отличается от принципа, используемого в компьютерах на основе процессоров с фон-неймановской архитектурой (с логич. базисом И, ИЛИ, НЕ). Вместо классич. программирования (как в традиц. вычислит. системах) применяется обучение Н. с., которое сводится, как правило, к настройке весовых коэффициентов с целью оптимизации заданного критерия качества функционирования Н. с. Нейросетевым алгоритмом решения задач называется вычислит. процедура, осн. часть которой или она целиком реализована в виде Н. с. той или иной структуры (напр., многослойная Н. с. с последовательными или перекрёстными связями между слоями формальных нейронов) с соответствующим алгоритмом настройки весовых коэффициентов. Основой разработки нейросетевого алгоритма является системный подход, при котором процесс решения задачи представляется как функционирование во времени некоторой динамич. системы. Для её построения необходимо определить: объект, выступающий в роли входного сигнала Н. с.; объект, выступающий в роли выходного сигнала Н. с. (напр., непосредственно решение или некоторая его характеристика); желаемый (требуемый) выходной сигнал Н. с.; структуру Н. с. (число слоёв, связи между слоями, объекты, служащие весовыми коэффициентами); функцию ошибки системы (характеризующую отклонение желаемого выходного сигнала Н. с. от реального выходного сигнала); критерий качества системы и функционал её оптимизации, зависящий от ошибки; значение весовых коэффициентов (напр., определяемых аналитически непосредственно из постановки задачи, с помощью некоторых численных методов или процедуры настройки весовых коэффициентов Н. с.).

Количество и тип формальных нейронов в слоях, а также число слоёв нейронов выбираются исходя из специфики решаемых задач и требуемого качества решения. Н. с. в процессе настройки на решение конкретной задачи рассматривается как многомерная нелинейная система, которая в итерационном режиме целенаправленно ищет оптимум некоторого функционала, количественно определяющего качество решения поставленной задачи. Для Н. с., как многомерных нелинейных объектов управления, формируются алгоритмы настройки множества весовых коэффициентов. Осн. этапы исследования Н. с. и построения алгоритмов настройки (адаптации) их весовых коэффициентов включают: исследование характеристик входного сигнала для разл. режимов работы Н. с. (входным сигналом Н. с. является, как правило, входная обрабатываемая информация и указание т. н. учителя нейронной сети); выбор критериев оптимизации (при вероятностной модели внешнего мира такими критериями могут быть минимум средней функции риска, максимум апостериорной вероятности, в частности при наличии ограничений на отд. составляющие средней функции риска); разработка алгоритма поиска экстремумов функционалов оптимизации (напр., для реализации алгоритмов поиска локальных и глобального экстремумов); построение алгоритмов адаптации коэффициентов Н. с.; анализ надёжности и методов диагностики Н. с. и др.

Достоинствами Н. с. являются: свойство т. н. постепенной деградации – при выходе из строя отд. элементов качество работы системы падает постепенно (для сравнения, логич. сети из элементов И, ИЛИ, НЕ выходят из строя при нарушении работы любого элемента сети); повышенная устойчивость к изменению параметров схем, их реализующих (напр., весьма значит. изменения весовых коэффициентов не приводят к ошибкам в реализации простой логич. функции двух переменных) и др.

Широкое распространение нейросетевых алгоритмов в области сложных формализуемых, слабоформализуемых и неформализуемых задач привело к созданию нового направления в вычислит. математике – нейроматематики. Нейроматематика включает нейросетевые алгоритмы решения следующих задач: распознавание образов; оптимизация и экстраполяция функций; теория графов; криптографич. задачи; решение вещественных и булевских систем линейных и нелинейных уравнений; обыкновенных одномерных и многомерных дифференциальных уравнений; дифференциальных уравнений в частных производных и др.

На основе теории Н. с. создан новый раздел совр. теории управления сложными нелинейными и многомерными, многосвязными динамич. системами, включающий методы нейросетевой идентификации сложных динамич. объектов; построение нейрорегуляторов в контурах управления сложными динамич. объектами и др.